MacBook部署chatglm3-6b

下载代码

git clone https://github.com/THUDM/ChatGLM3

cd ChatGLM3

pip install -r requirements.txt本地加载模型

Huggingface 国内网络问题推荐使用镜像站:hf-mirror 支持断点续传

demo

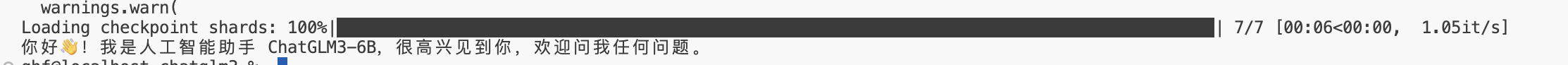

MacBook M1 Pro 16g 部署

from transformers import AutoTokenizer, AutoModel

# 本地模型

model_directory = "模型地址路径(推荐绝对路径)"

#model_directory = "THUDM/chatglm3-6b"

tokenizer = AutoTokenizer.from_pretrained(model_directory, trust_remote_code=True)

model = AutoModel.from_pretrained(model_directory, trust_remote_code=True).half().to('mps')

model = model.eval()

response, history = model.chat(tokenizer, "你好", history=[])

print(response)

速度感人,20分钟才出结果。电脑配置不行放弃治疗。。。

mac优化:

将/ChatGLM3/composite_demo/client.py

中的第140行左右

中的

device_map = “auto”

改为

device_map = “mps”环境变量:

export MODEL_PATH=本地模型路径。指定从本地加载模型

Jupyter 内核,可以通过 export IPYKERNEL=<kernel_name> 来指定。